Các nhà nghiên cứu bảo mật vừa phát hiện một loạt lỗ hổng thực thi mã từ xa nghiêm trọng, ảnh hưởng đến các AI inference engine lớn từ Meta, Nvidia, Microsoft và nhiều dự án mã nguồn mở phổ biến khác.

Theo báo cáo từ Oligo Security, các lỗ hổng này đều xuất phát từ cùng một nguyên nhân gốc rễ: việc sử dụng không an toàn ZeroMQ (ZMQ) và cơ chế pickle deserialization của Python. Mô hình lỗi này, được đặt tên là ShadowMQ, đã vô tình lan truyền sang nhiều dự án do việc tái sử dụng mã.

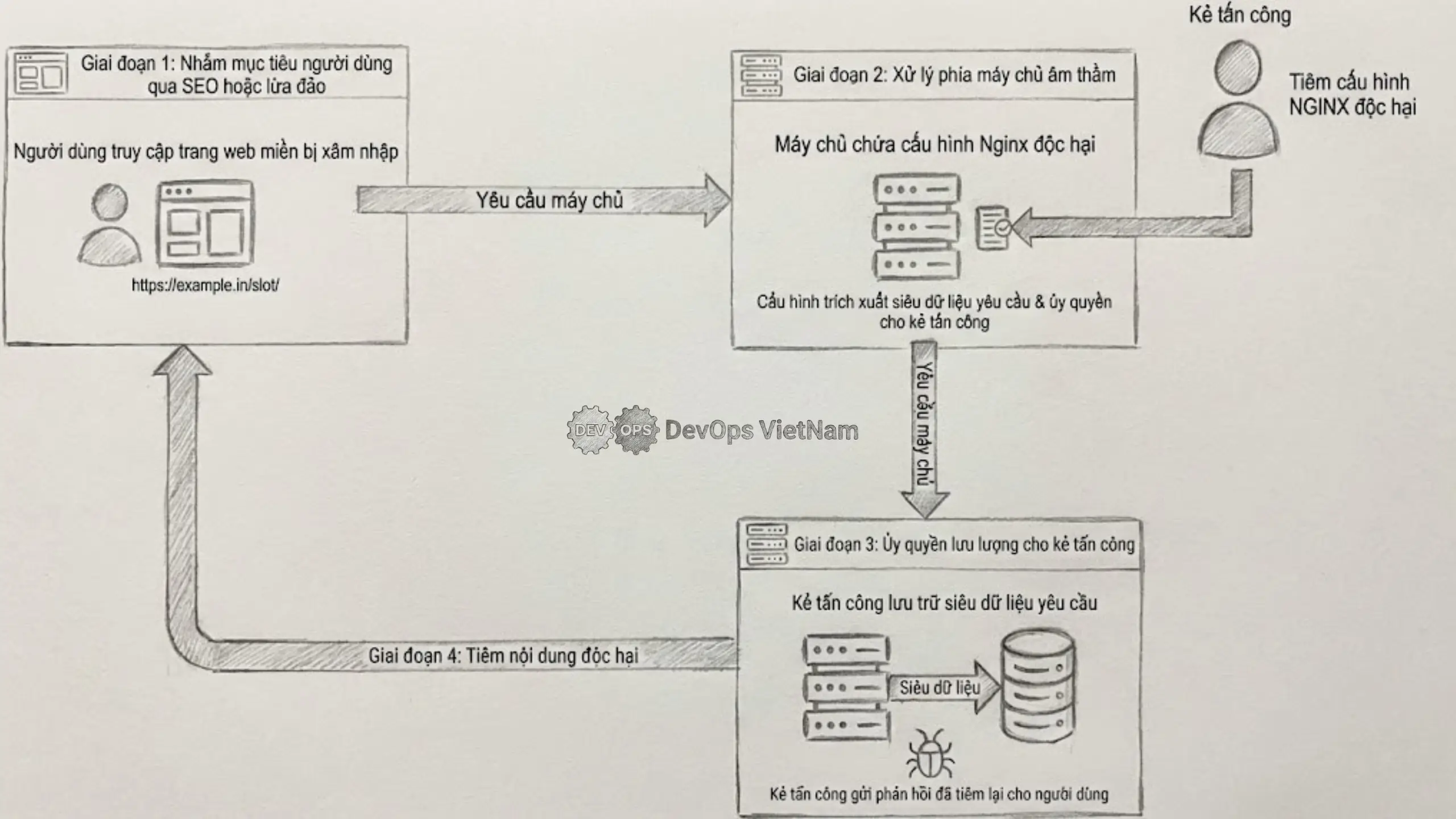

Vấn đề bắt nguồn từ một lỗ hổng trong framework Llama của Meta (CVE-2024-50050), cụ thể là việc sử dụng phương thức recv_pyobj() của ZeroMQ để deserialization dữ liệu. Khi socket ZMQ này bị lộ ra mạng, kẻ tấn công có thể gửi dữ liệu độc hại và thực thi mã tùy ý.

Điều đáng lo ngại là mô hình không an toàn này đã được sao chép sang các dự án khác. Báo cáo chỉ ra rằng SGLang đã sử dụng mã từ vLLM, trong khi Modular Max Server mượn logic từ cả vLLM và SGLang, khiến lỗi bảo mật nghiêm trọng này lan rộng. Các framework bị ảnh hưởng bao gồm NVIDIA TensorRT-LLM (CVE-2025-23254), Microsoft Sarathi-Serve (chưa vá), vLLM (CVE-2025-30165) và SGLang.

Việc khai thác thành công một node inference có thể cho phép kẻ tấn công thực thi mã tùy ý trên cluster, leo thang đặc quyền, thực hiện hành vi đánh cắp mô hình, hoặc cài cắm các payload độc hại như mã độc đào tiền ảo. Các chuyên gia an ninh mạng nhấn mạnh rằng tốc độ phát triển chóng mặt của AI đã thúc đẩy việc tái sử dụng code, nhưng khi mã đó chứa các pattern không an toàn, hậu quả sẽ lan truyền rất nhanh.