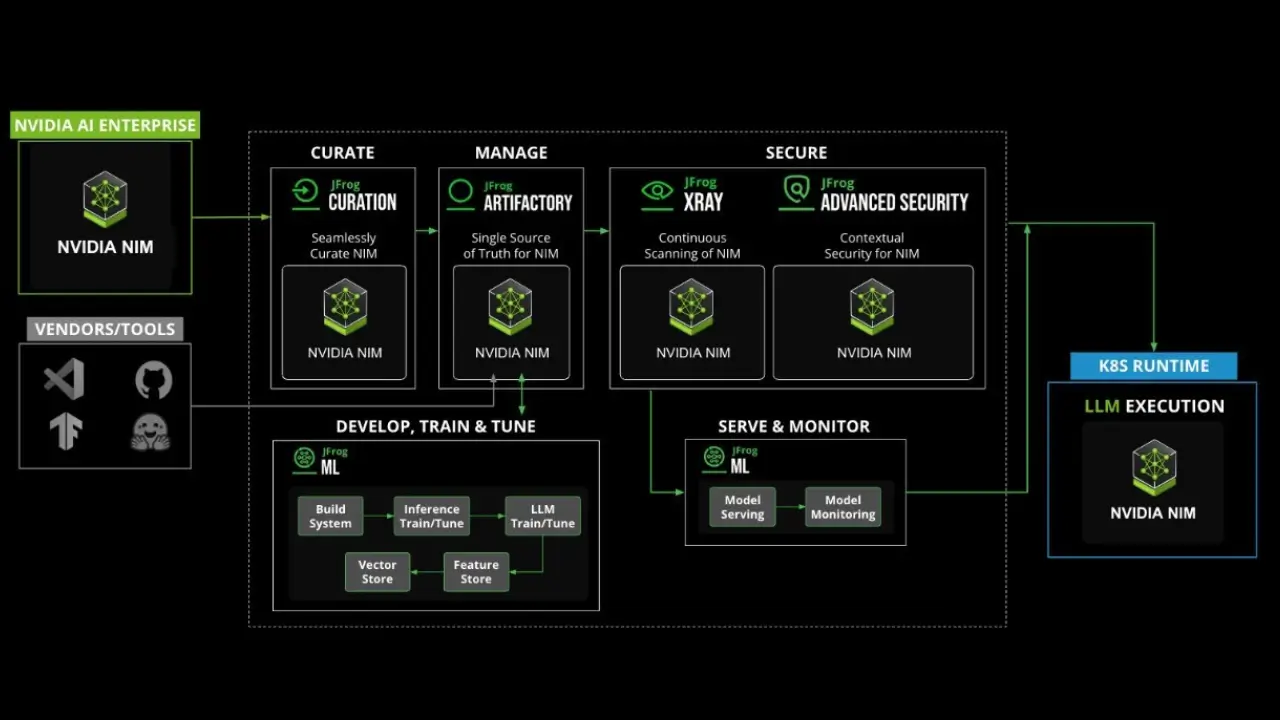

JFrog và NVIDIA vừa công bố việc tăng cường tích hợp giữa các nền tảng phát triển phần mềm của hai bên, trong đó có Enterprise AI Factory. Đây là một bộ công cụ và mẫu thiết kế dành riêng cho việc phát triển ứng dụng trí tuệ nhân tạo. Nhờ sự hợp tác này, các sản phẩm phần mềm được tạo ra từ Enterprise AI Factory của NVIDIA có thể được lưu trữ trực tiếp trên nền tảng quản lý chuỗi cung ứng phần mềm của JFrog. Bên cạnh đó, nền tảng JFrog ML đóng vai trò như một kho lưu trữ, hỗ trợ quản lý toàn bộ vòng đời phát triển và triển khai mô hình AI. Việc này bao gồm kiểm soát phiên bản, truy xuất nguồn gốc, nâng cấp mô hình và đảm bảo các chính sách bảo mật luôn được thực thi.

Một điểm nổi bật khác là hệ thống quản lý metadata và quy trình thăng cấp của JFrog giúp đảm bảo các sản phẩm AI chỉ được chuyển sang giai đoạn tiếp theo khi đã vượt qua tất cả các bước kiểm tra về chất lượng, an ninh và pháp lý. Các mô hình AI cũng có thể được lưu tạm thời, theo dõi liên tục và cập nhật kịp thời để đáp ứng các quy định hiện hành. Việc cập nhật các bản vá quan trọng và mô hình AI cũng được quản lý tập trung, giúp tối ưu hóa quy trình vận hành. Ngoài ra, nền tảng JFrog ML còn cho phép các nhóm phát triển áp dụng kiểm soát truy cập dựa trên vai trò, giúp mọi hoạt động truy cập vào sản phẩm AI đều được ghi nhận phục vụ cho việc tuân thủ.

Những tính năng này kết hợp lại giúp đảm bảo mọi phần mềm AI đều phải được xác thực, ký số và phê duyệt trước khi triển khai thực tế. Kristian Taernhed, quản lý liên minh kỹ thuật cấp cao tại JFrog, cho biết mục tiêu của họ là cung cấp một kho lưu trữ có thể triển khai tại chỗ, hỗ trợ các nhóm DevSecOps quản lý toàn bộ sản phẩm phần mềm, bao gồm cả các agent và mô hình AI. Điều này cho phép tổ chức sử dụng các công cụ quét để phát hiện và ngăn chặn những mô hình AI độc hại bị tích hợp vào ứng dụng.

Việc bảo vệ chuỗi cung ứng phần mềm phục vụ phát triển AI ngày càng trở nên quan trọng, đặc biệt với các tổ chức hoạt động trong lĩnh vực chịu sự kiểm soát nghiêm ngặt hoặc các quốc gia đã ban hành quy định về phát triển AI, còn gọi là Sovereign AI. Các yêu cầu này thường đòi hỏi dữ liệu và phần mềm AI phải được quản lý trong phạm vi địa lý hoặc tổ chức nhất định, đồng thời áp dụng các biện pháp kiểm soát nghiêm ngặt xuyên suốt chuỗi cung ứng.

Hiện tại, mức độ tích hợp giữa các quy trình vận hành máy học và DevOps vẫn còn là dấu hỏi, nhưng về bản chất, các mô hình AI cũng chỉ là một dạng sản phẩm cần được tích hợp vào quy trình xây dựng phần mềm. Khi ngày càng nhiều ứng dụng tích hợp AI, số lượng mô hình cần đưa vào quy trình DevOps chắc chắn sẽ tiếp tục tăng. Thách thức lớn nhất có lẽ là dung hòa giữa văn hóa làm việc của các nhóm khoa học dữ liệu và các nhóm DevOps hoặc kỹ sư nền tảng, những người chịu trách nhiệm xây dựng và vận hành phần mềm. Trong bối cảnh đó, việc tích hợp nhiều nền tảng xây dựng mô hình AI vào quy trình DevSecOps là điều không thể tránh khỏi. Dù một số tổ chức có thể chuẩn hóa trên một số nền tảng nhất định, nhưng với tốc độ phát triển công nghệ hiện nay, số lượng nền tảng được sử dụng sẽ tiếp tục tăng. Đa số các nhóm khoa học dữ liệu cũng giống như DevOps, đều mong muốn kiểm soát công cụ và nền tảng của mình, nên việc áp dụng tiêu chuẩn chung trong ngắn hạn sẽ gặp nhiều khó khăn.

Tuy vậy, mỗi lần tích hợp thành công sẽ giúp các nhóm nâng cao chuyên môn, từ đó các dự án về sau sẽ thuận lợi hơn.