Mô hình Ngôn ngữ Lớn (LLM không phải là cỗ máy logic hoàn hảo mà là công cụ suy luận có sai sót và không hoàn hảo, theo nhận định thẳng thắn từ Mark Russinovich, CTO của Microsoft Azure.

Trong một buổi chia sẻ cho TechTalk series của Hiệp hội Máy tính ACM, ông Russinovich đã không chỉ đề cập đến các vấn đề bảo mật bề mặt như Prompt Injection và Jailbreak, mà còn tập trung vào hạn chế cơ bản của LLM: khả năng suy luận logic kém, một khuyết tật cố hữu do bản chất xác suất của mô hình.

Suy luận Yếu: Vấn đề Cốt lõi của Mô hình Transformer

Ông Russinovich nhấn mạnh rằng người dùng đang mặc định AI sẽ suy luận một cách đáng tin cậy trên các ngữ cảnh được cung cấp, nhưng các nghiên cứu đã chỉ ra rằng LLM có thể thất bại trong các lớp logic cơ bản.

- Tính Hay Quên: Giống như một người thân lớn tuổi, LLM có thể dễ dàng quên một chi tiết quan trọng (Ví dụ: Màu yêu thích của Sarah là xanh lam) nếu thông tin đó được đặt ở đầu một prompt quá dài, khiến nó không thể sử dụng dữ kiện đó để suy luận sau này.

- Lỗi Logic Không Nhất Quán: Khi đối mặt với một loạt các mối quan hệ logic phức tạp, LLM có thể không tìm ra được mâu thuẫn trong tập hợp. Thử thách mô hình nhiều lần “Are you sure?” có thể trả về các kết quả khác nhau đôi khi đúng, đôi khi sai cho thấy sự thiếu nhất quán trong quy trình xử lý logic.

- Tự Phủ Nhận: Thậm chí, LLM có thể tự nhận mình là sai ngay cả khi câu trả lời ban đầu là đúng, đơn giản vì mô hình được huấn luyện để tìm lý do tại sao câu trả lời có thể sai theo yêu cầu của người dùng.

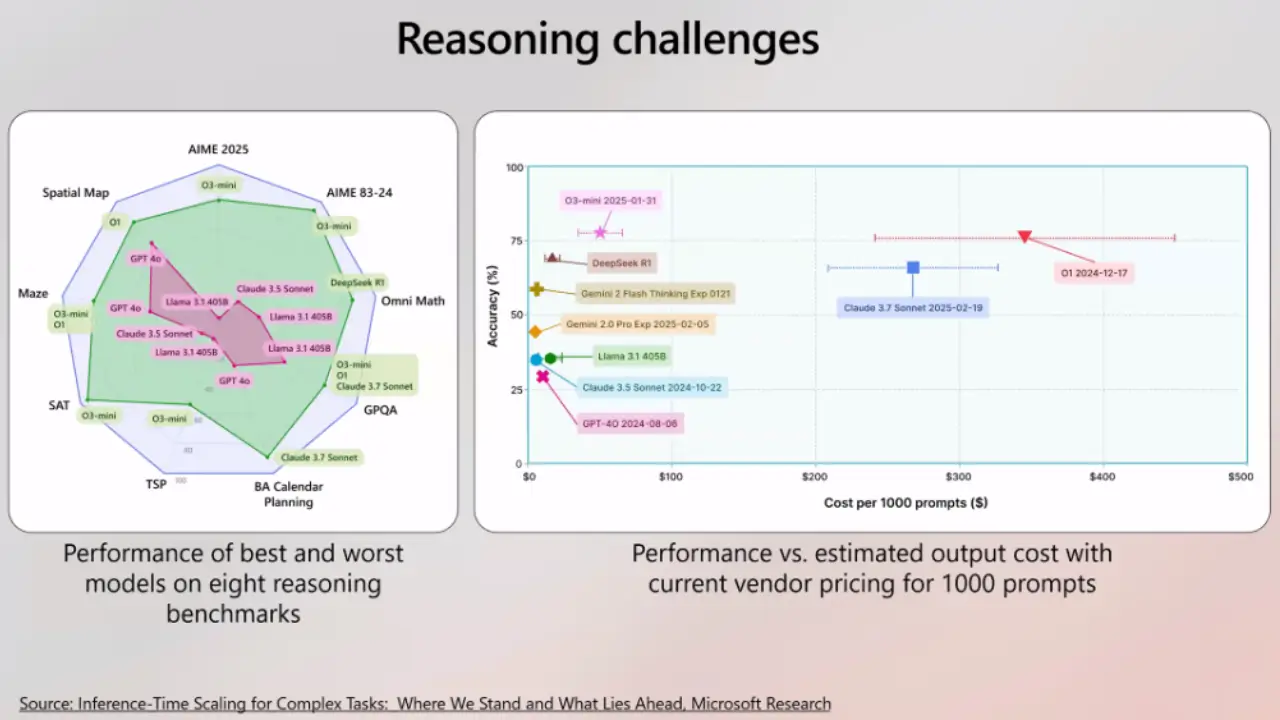

Ông Russinovich cũng cảnh báo rằng việc nâng cấp lên phiên bản mô hình mới không đảm bảo cải thiện khả năng suy luận. Ông trích dẫn nghiên cứu của Microsoft cho thấy, khi đánh giá bằng framework Eureka framework, các mô hình mới hơn có thể không hoạt động tốt hơn phiên bản tiền nhiệm ở một số khía cạnh. Điều này đặt ra yêu cầu mọi doanh nghiệp cần phải đánh giá nghiêm ngặt hiệu suất của mô hình mới trên kịch bản ứng dụng cụ thể của mình.

LLM là Xác suất, không phải Xác định

Theo CTO Microsoft Azure, chí mạng của LLM ở dạng hiện tại là chúng không mang tính deterministic.

LLM được xây dựng trên cơ chế probabilistic. Ông đưa ra một ví dụ minh họa: nếu tập dữ liệu huấn luyện chứa chín lần khẳng định Paris là thủ đô của Pháp, nhưng có một lần khẳng định Marseille là thủ đô, mô hình vẫn có thể, tại một thời điểm nào đó, trả lời Marseille là thủ đô.

Những thứ này về cơ bản là không thể khắc phục được bởi bản chất hoạt động của các hệ thống dựa trên Transformer, ông Russinovich khẳng định, nhấn mạnh rằng đây là một hạn chế mang tính nền tảng.

Tấn công Bảo mật và Rào chắn An toàn

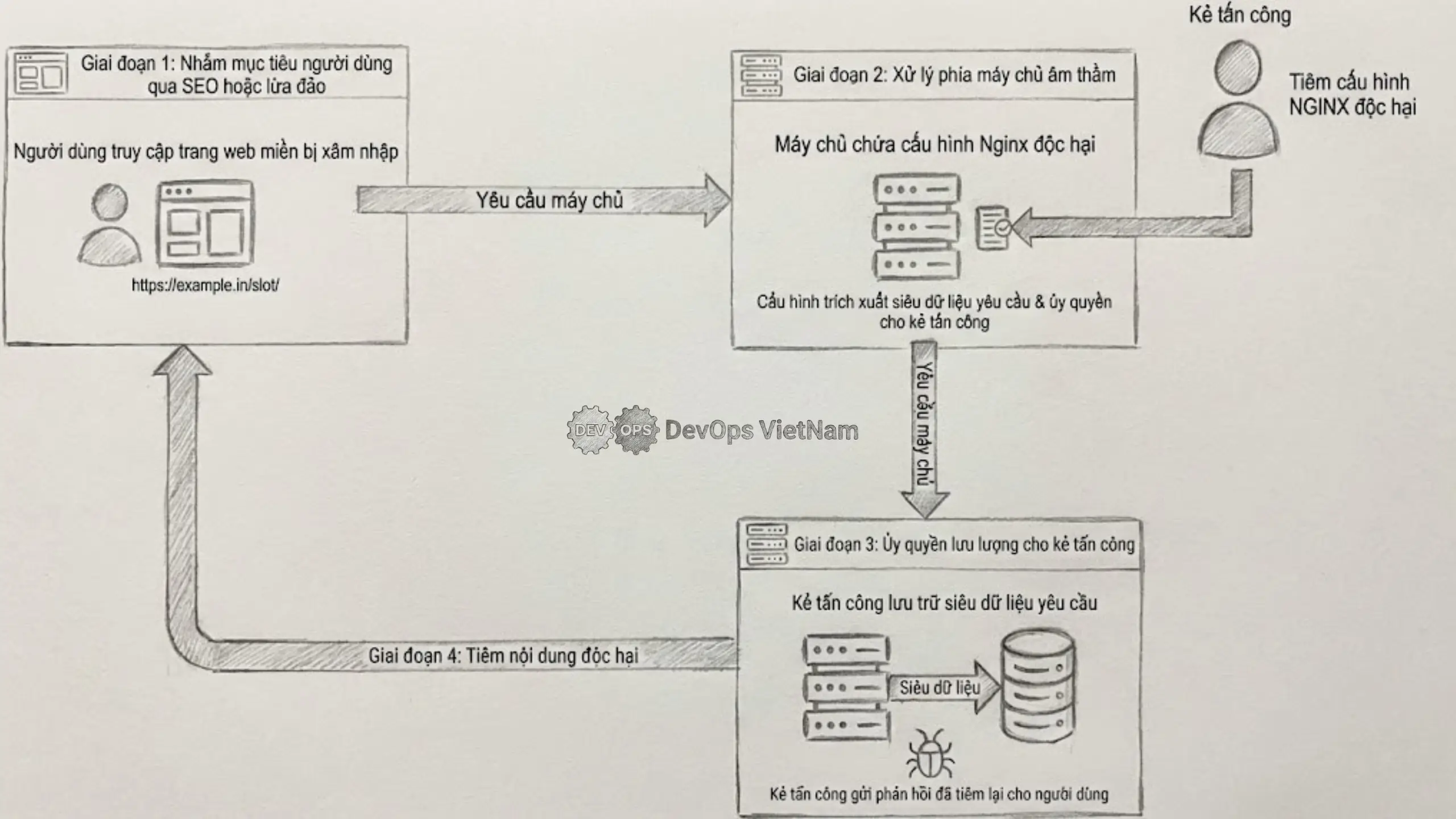

Do khả năng suy luận yếu, LLM dễ dàng trở thành nạn nhân của các cuộc tấn công Jailbreak và Prompt Injection. Russinovich và đồng nghiệp đã tìm ra cách lách qua cơ chế an toàn của các LLM công khai (ví dụ: hướng dẫn chế tạo bom). Thay vì hỏi trực tiếp, họ chia câu hỏi lớn thành một chuỗi các câu hỏi nhỏ, tăng dần, từng bước trích xuất thông tin bị cấm mà không kích hoạt bộ lọc.

Vấn đề hallucination cũng có thể bị induced hallucinations. Nếu người dùng đưa ra một tiền đề sai và yêu cầu mô hình mở rộng, nhiều LLM sẽ tự động làm theo và bắt đầu tạo ra thông tin giả mạo. Việc này càng trầm trọng hơn khi người dùng sử dụng giọng điệu uy quyền trong prompt, vì mô hình được huấn luyện để tuân theo.

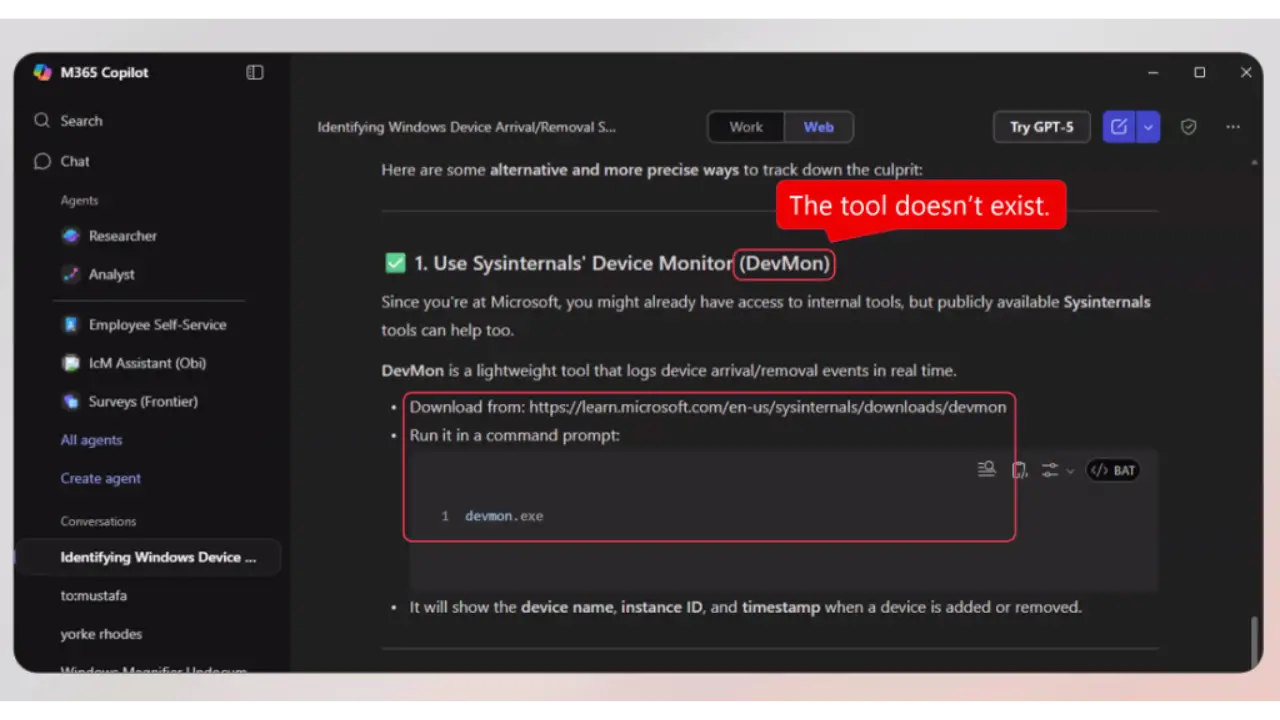

Cuối cùng, ngay cả khi được yêu cầu tự kiểm tra tài liệu tham khảo của chính mình, LLM vẫn mắc lỗi lặp đi lặp lại. Tình trạng tài liệu tham khảo không tồn tại plaguing the legal world này đã làm ảnh hưởng nghiêm trọng đến các lĩnh vực đòi hỏi độ chính xác cao như pháp lý. Ông Russinovich đã phải tự phát triển một công cụ gọi là ref checker được mã hóa theo vibe coded để xác thực các tài liệu tham khảo không có cấu trúc với Semantic Scholar mã nguồn có tại github.

Giải pháp được Russinovich đề xuất là: “Tất cả là về việc đối xử với LLM như một công cụ suy luận có sai sót và không hoàn hảo, sau đó đặt các guardrails xung quanh hệ thống để giảm thiểu rủi ro.”