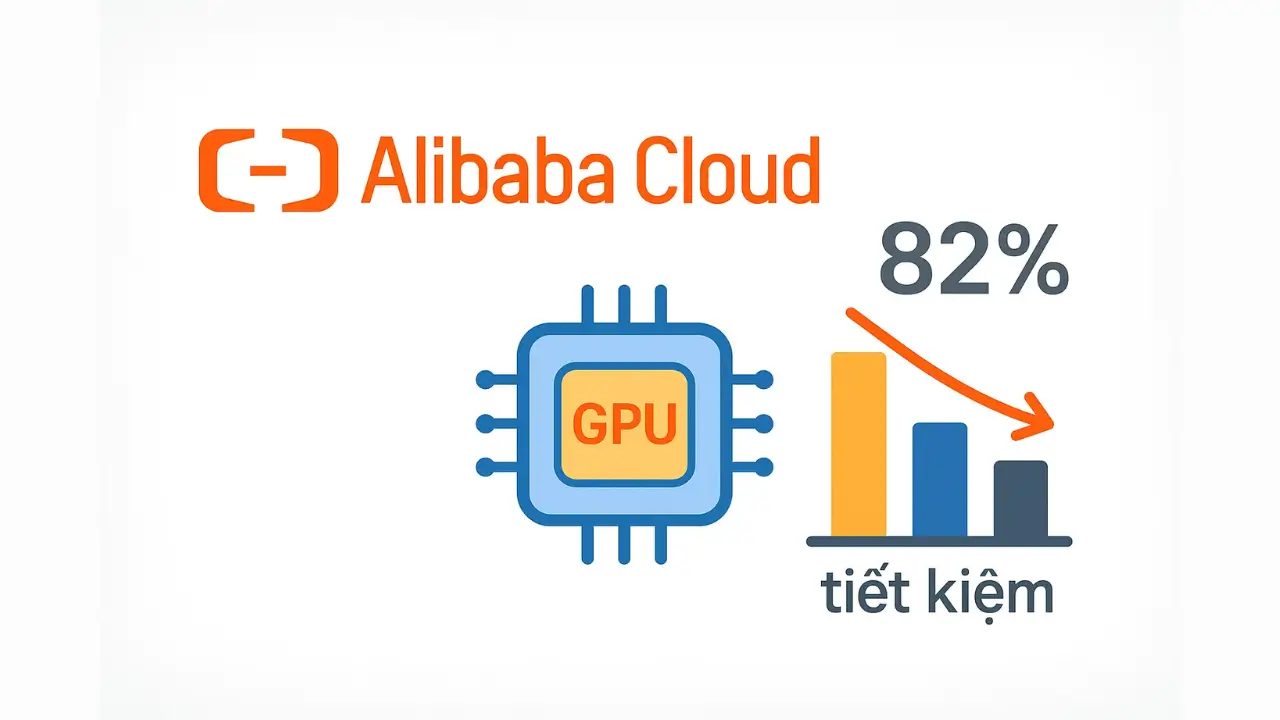

Gã khổng lồ công nghệ Trung Quốc Alibaba vừa công bố Aegaeon, một công nghệ scheduling và GPU pooling mới. Công nghệ này giúp tối ưu hóa việc chạy các mô hình AI inferencing, đạt mức tiết kiệm tài nguyên GPU đến 82% cho các mô hình ít sử dụng. Tuy nhiên, đây là một đột phá về vận hành, không phải là một DeepSeek moment làm thay đổi cuộc chơi training AI.

Trong một bài báo nghiên cứu được trình bày tại hội nghị ACM SIGOPS 31st, Alibaba chỉ ra sự lãng phí lớn trong việc phục vụ các mô hình AI inferencing. Mặc dù các mô hình như Hugging Face có hàng triệu mô hình, người dùng chủ yếu chỉ dùng một vài mô hình phổ biến. Alibaba Cloud phát hiện ra rằng họ phải dành tới 17.7% cụm GPU của mình chỉ để phục vụ 1.35% yêu cầu từ các mô hình ít được sử dụng.

Nguyên nhân là do các nhà cung cấp thường cấu hình GPU chỉ chạy 2-3 mô hình (do giới hạn bộ nhớ), dẫn đến hàng nghìn GPU bị treo chỉ để chờ phục vụ các mô hình không phổ biến. Điều này đặc biệt tốn kém và là vấn đề lớn với Alibaba, trong bối cảnh họ gặp khó khăn khi mua chip từ Nvidia và AMD do các lệnh trừng phạt của Mỹ.

Để giải quyết vấn đề này, Alibaba đã phát triển Aegaeon. Đây là công nghệ GPU pooling và quản lý bộ nhớ thông minh. Aegaeon cho phép chạy nhiều mô hình hơn trên mỗi GPU lên đến hàng chục mô hình bằng cách chia sẻ tài nguyên và offload dữ liệu sang host memory hoặc bộ lưu trữ khác khi cần.

Kết quả thử nghiệm beta trong ba tháng rất ấn tượng: Alibaba đã giảm số lượng GPU chuyên dụng cho các mô hình ít dùng từ 1.192 xuống chỉ còn 213, tiết kiệm 82% tài nguyên GPU. Tuy nhiên, các chuyên gia nhấn mạnh đây là một cải tiến về hiệu suất vận hành, không phải là một DeepSeek moment như hồi tháng 1 năm 2025 vốn là một đột phá giúp giảm đáng kể lượng GPU cần thiết cho training mô hình.

Bài báo này cũng cho thấy hệ thống trước đây của Alibaba hoạt động không hiệu quả. Hơn nữa, có khả năng các hyperscaler khác (như AWS, Google) đã có công nghệ tương tự hoặc tốt hơn nhưng không công bố. Dù vậy, nghiên cứu này vẫn quan trọng vì nó mở đường cho các nền tảng cloud chạy các mô hình AI chuyên biệt ít phổ biến một cách hiệu quả, giúp giảm giá thành dịch vụ AI trong tương lai.